La détection d'objets ne se limite pas à une prouesse technologique ; elle est la pierre angulaire de la vision par ordinateur moderne. En fusionnant localisation et classification, elle permet d'identifier et de situer avec précision des éléments au sein d'images ou de flux vidéo. Cette capacité est devenue indispensable dans une pluralité de secteurs : sécurité publique, automatisation industrielle, diagnostic médical, robotique avancée, et même pour nos voitures autonomes qui sillonnent nos routes avec une assurance croissante. Imaginez des diagnostics médicaux accélérés, des chaînes de production intelligentes et une sécurité renforcée. Tout cela, et bien plus, est rendu possible par la détection d'objets. Dans cet article, nous allons explorer en profondeur l'un des algorithmes les plus emblématiques de ce domaine : YOLO.

YOLO, acronyme de "You Only Look Once", est un algorithme de détection d'objets qui a marqué une rupture. Sa particularité ? Analyser les images en une unique passe, ce qui réduit drastiquement le temps de traitement sans sacrifier les performances. Cette combinaison d'efficacité et de justesse a propulsé YOLO au rang des modèles de référence en vision par ordinateur. Avec une évolution constante portée par une communauté active et des acteurs tel que l’entreprise Ultralytics, YOLO continue de repousser les limites, comme en témoignent les recherches autour de versions avancées telles que YOLOv12.

L'évolution de YOLO est intimement liée à ses figures de proue successives. Initialement porté par Joseph Redmon, créateur des versions YOLOv1 à YOLOv3 sous le framework Darknet, le projet a connu un tournant majeur lorsque Redmon s'est retiré de la recherche en vision par ordinateur début 2020 pour des raisons éthiques. Ce retrait n'a pas signifié la fin de YOLO, mais plutôt le début d'une nouvelle ère de contributions diversifiées. Alors que des chercheurs comme Alexey Bochkovskiy et son équipe ont brillamment assuré une continuité avec YOLOv4, prolongeant l'héritage Darknet, l'écosystème était mûr pour une approche axée sur une plus grande accessibilité. C'est dans ce contexte qu'Ultralytics, sous l'impulsion de Glenn Jocher, a véritablement catalysé la démocratisation de YOLO. En réimplémentant et en étendant les concepts fondamentaux de YOLO nativement en PyTorch avec des modèles comme YOLOv5, puis YOLOv8, l’entreprise Ultralytics n'a pas seulement offert des performances de pointe, mais a surtout abaissé drastiquement la barrière à l'entrée. Leur framework a simplifié l'entraînement, la personnalisation et le déploiement de modèles YOLO, les rendant accessibles à une communauté mondiale de développeurs, de chercheurs et d'entreprises.

En vision par ordinateur, l'interprétation et la localisation d'objets dans les images reposent sur des algorithmes sophistiqués. Deux approches principales ont longtemps coexisté, chacune avec ses forces et ses faiblesses.

Les CNN excellent par leur rapidité d'analyse. Ils fonctionnent en appliquant des filtres sur l'image pour identifier progressivement des éléments simples (contours, formes…) puis des combinaisons plus complexes (yeux, roues…). Cette méthode, très efficace et rapide grâce à des calculs optimisés, est à la base de nombreux algorithmes de vision, y compris les premières versions de YOLO. Cependant, les CNN peuvent avoir du mal à saisir les relations complexes entre des objets éloignés ou le contexte global d'une image avec autant de précision que d'autres techniques. Par exemple, pour reconnaître un "ballon de football", le CNN aura du mal à faire le lien avec la présence de cage de football localisée de l’autre côté de l’image.

Plus récemment, les Transformers, avec leur mécanisme d'attention, ont suscité un grand intérêt. L'attention permet à l'algorithme d'évaluer l'importance relative des différentes parties d'une image (ou d'un texte) les unes par rapport aux autres. Cela lui confère la capacité de connecter des informations distantes et de se concentrer sur l'essentiel pour interpréter des scènes complexes avec une grande précision. En reprenant l’exemple du "ballon de football", le Transformer peut accorder plus d'importance à la présence de cage de football localisée de l’autre côté de l’image. L'inconvénient majeur des Transformers réside dans leur forte demande en puissance de calcul, les rendant souvent plus lents que les CNN, ce qui peut être problématique pour les applications en temps réel. Parmi les modèles Transformer on peut nommer DETR étant actuellement l’un des meilleurs modèles de computer vision. En comparaison, la version moyenne de la série 12 de YOLO est 3 fois plus petite que DETR.

Les créateurs de YOLO ont cherché à combiner les avantages de ces deux approches. Tout en conservant l'architecture efficace des CNN pour la rapidité, ils ont intégré des mécanismes d'attention plus légers et optimisés. L'objectif n'est pas d'utiliser l'attention "lourde" des Transformers de manière systématique, mais de l'appliquer de façon ciblée et ingénieuse. Par exemple, grâce à l'architecture d’Attention Localisée (ie "Area Attention"), YOLO apprend à concentrer son attention sur des zones spécifiques de l'image en la segmentant et en identifiant les zones qui nécessitent une analyse plus approfondie, sans avoir à calculer les relations entre tous les pixels. D'autres optimisations techniques, telles que "Flash Attention" ou la simplification du réseau, contribuent à rendre l'utilisation de l'attention compatible avec la vitesse caractéristique de YOLO.

En résumé, YOLO réalise un compromis astucieux en exploitant la rapidité des CNN pour l'analyse globale et en y intégrant des éléments d'intelligence contextuelle inspirés des Transformers. Cela lui permet d'améliorer la précision de la détection dans des scènes complexes sans sacrifier sa rapidité, à l'image d'un athlète rapide qui développe également des compétences d'observation et de stratégie.

La polyvalence et la rapidité de YOLO lui ont ouvert les portes de nombreux secteurs, transformant des défis complexes en solutions tangibles.

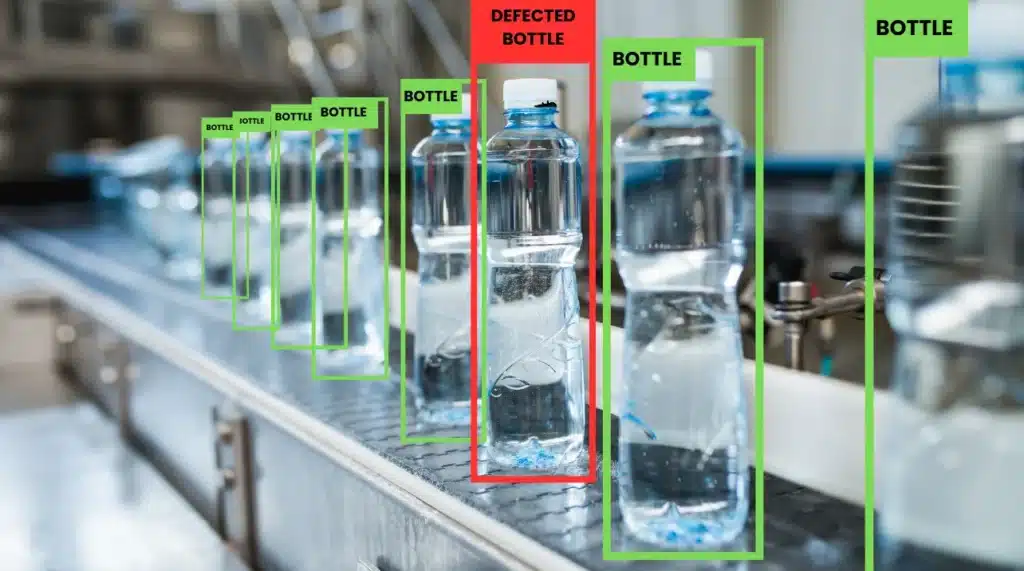

Dans le secteur manufacturier, YOLO automatise le contrôle qualité en repérant les défauts sur les chaînes de production, améliorant l'efficacité et réduisant les coûts.

La conduite autonome exige une perception infaillible de l'environnement. YOLO détecte piétons, véhicules, signalisation et obstacles, assurant une navigation plus sûre et fiable.

YOLO révolutionne la surveillance en analysant les flux vidéo pour identifier comportements suspects, intrusions ou objets abandonnés, renforçant la sécurité des biens et des personnes.

En agriculture, YOLO aide à identifier les maladies des plantes, détecter les mauvaises herbes, ou encore surveiller le bétail, optimisant les rendements et favorisant une agriculture durable.

La rapidité et la précision sont vitales en médecine. YOLO assiste les praticiens en détectant des anomalies sur des images médicales (radios, IRM), comme les tumeurs ou fractures, pour des diagnostics plus prompts.

Lors de catastrophes, une évaluation rapide des dégâts est cruciale. YOLO, analysant des images aériennes ou satellitaires (par exemple, pour le recensement d’habitation rural dans les pays défavorisés), aide à coordonner les secours et à acheminer l'aide efficacement. C’est l’un des projets conduit par l’Aqsone Lab en participant au projet Disaster Vulnerability Challenge proposé par la plateforme Zindi.

Le framework Ultralytics est conçu pour simplifier et accélérer le développement de solutions en vision par ordinateur. En fournissant un ensemble complet d'outils préconstruits, de modèles pré-entraînés et de fonctionnalités modulaires, il permet aux chercheurs et aux développeurs de se concentrer sur les aspects spécifiques de leurs projets plutôt que de devoir construire les fondations à partir de zéro. Explorons en détail certains des outils et des avantages clés offerts par ce framework puissant.

Pour garantir la robustesse d'un modèle, un entraînement sur un volume important et varié de données est essentiel. Afin d'accroître cette diversité sans acquérir de nouvelles images, des techniques d'augmentation de données sont utilisées. Celles-ci comprennent des transformations classiques (recadrage, retournement, rotation, modification de la luminosité et du contraste) ainsi que des méthodes plus sophistiquées comme Mosaic (combinant quatre images en une seule) ou MixUp (mélange pondéré d'images et de leurs étiquettes). L'application de ces techniques permet d'exposer le modèle à un éventail plus large de situations, ce qui améliore sa capacité à généraliser.

Lors de la phase d'inférence (prédiction), la Test-Time Augmentation (TTA) peut améliorer les performances. Elle consiste à appliquer plusieurs transformations à l'image de test, à obtenir des prédictions pour chaque version transformée, puis à agréger ces prédictions (par exemple, par vote majoritaire ou moyenne). Bien que plus coûteuse en temps, cette méthode peut significativement augmenter la précision et le rappel du modèle.

La librairie python mise à disposition par Ultralytics ne se limite pas à la détection d'objets. Leur framework étend les capacités de YOLO à :

YOLO s'est imposé comme un algorithme de détection d'objets incontournable, alliant vitesse, précision et une adaptabilité remarquable. Son architecture novatrice et son évolution constante, portée par une communauté scientifique et des acteurs industriels dynamiques, lui permettent de s'illustrer dans une diversité impressionnante de domaines. Les avancées continues, comme celles explorées avec des modèles tels que YOLOv12-turbo (voir graphique de performance sur le dataset COCO, dataset de référence pour la détection d’objet), promettent de nouvelles capacités.

La flexibilité offerte par des frameworks comme celui d'Ultralytics, avec ses fonctionnalités avancées de segmentation, d'estimation de pose ou de détection orientée, fait de YOLO bien plus qu'un simple détecteur : c'est une véritable boîte à outils polyvalente pour la vision par ordinateur. Alors que l'intelligence artificielle continue de progresser, YOLO et ses dérivés sont assurément destinés à redéfinir encore les standards, ouvrant la voie à des applications toujours plus intelligentes et performantes.

Découvrez nos articles sur les dernières tendances, avancées ou applications de l’IA aujourd’hui.